Travel Tips

Lorem ipsum dolor sit amet, consectetur adipiscing elit.

Entenda como a entropia influencia a energia e a ordem dos sistemas.

A entropia é um conceito fundamental na termodinâmica e na física estatística, representando a medida da desordem ou aleatoriedade em um sistema. Em termos simples, quanto maior a entropia de um sistema, maior é sua desordem. Este conceito foi introduzido no século XIX pelo físico alemão Rudolf Clausius, que buscava entender a relação entre calor e trabalho em processos termodinâmicos.

Desde então, a entropia tem sido uma ferramenta crucial para descrever a direção dos processos naturais e a eficiência das máquinas térmicas.

A entropia é frequentemente associada à segunda lei da termodinâmica, que afirma que a entropia total de um sistema isolado sempre tende a aumentar ao longo do tempo. Isso implica que os processos naturais são irreversíveis e que a energia tende a se dispersar.

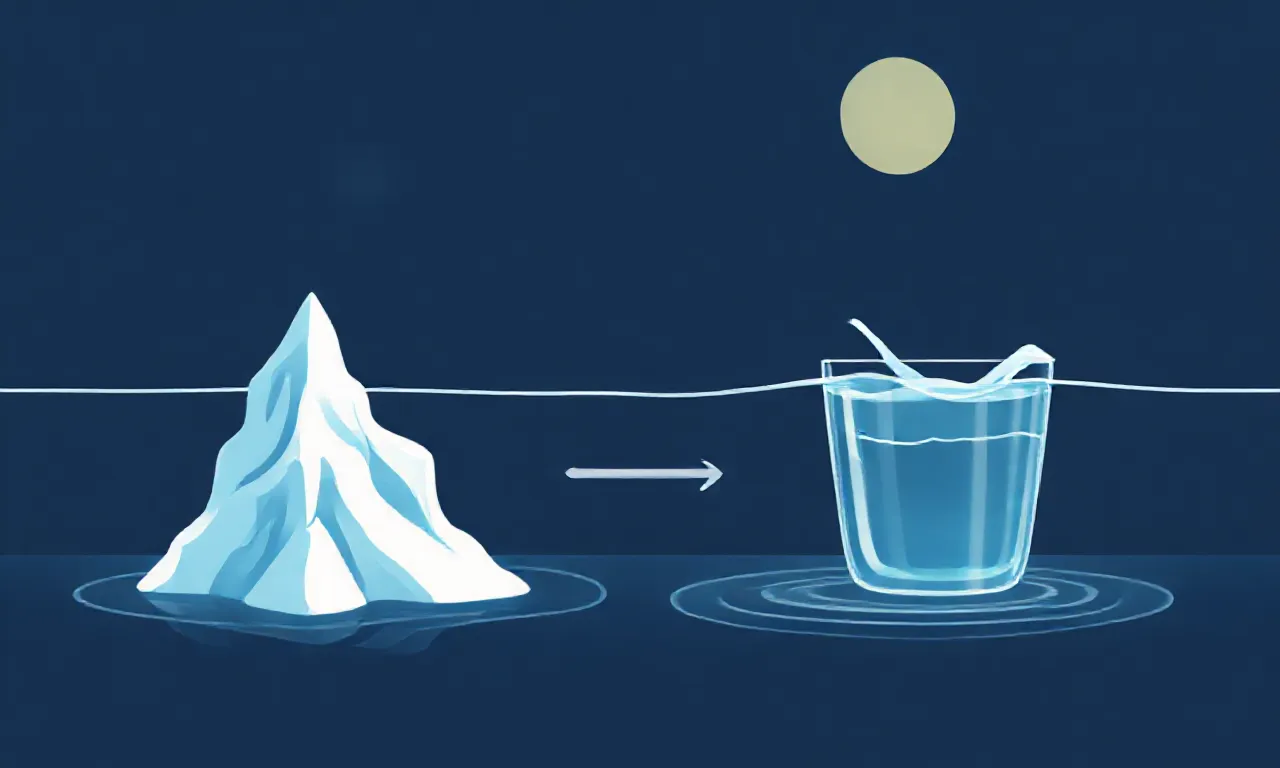

Um exemplo clássico é o derretimento de gelo em água: à medida que o gelo derrete, as moléculas de água, que estavam organizadas em uma estrutura sólida, tornam-se mais desordenadas, aumentando a entropia do sistema.

Para compreender a entropia de forma mais aprofundada, é importante considerar a definição estatística proposta por Ludwig Boltzmann. Ele relacionou a entropia (S) ao número de microestados (Ω) de um sistema através da famosa equação S = k log(Ω), onde k é a constante de Boltzmann.

Essa perspectiva permite visualizar a entropia não apenas como uma medida da desordem, mas também como uma representação da probabilidade de um sistema estar em um determinado estado. Quanto mais microestados disponíveis, maior a entropia.

A entropia também desempenha um papel crucial em processos químicos e biológicos.

Em reações químicas, a variação de entropia pode prever a espontaneidade da reação. Reações que resultam em um aumento da desordem, como a dissolução de um sólido em um líquido, tendem a ser espontâneas. Isso se relaciona à ideia de que a natureza favorece estados de maior desordem, refletindo a tendência geral do universo em se mover em direção ao equilíbrio.

Além disso, a entropia tem implicações significativas em áreas como a informação e a computação. Na teoria da informação, a entropia é usada para quantificar a incerteza ou a informação contida em uma mensagem. Isso se relaciona à entropia termodinâmica, pois ambos os conceitos lidam com a distribuição e a desordem.

A conexão entre esses campos mostra como a entropia é um conceito versátil que transcende as fronteiras da física.

Historicamente, a entropia também teve um impacto nas discussões filosóficas sobre o tempo e a irreversibilidade. A flecha do tempo, que descreve a direção em que os eventos ocorrem, está intimamente ligada ao aumento da entropia.

Em um universo em expansão, a entropia tende a aumentar, o que levanta questões sobre o destino final do cosmos e a natureza do tempo.

Por fim, a entropia é um conceito que permeia muitos aspectos da ciência e da vida cotidiana. Desde a eficiência de motores térmicos até a compreensão de processos naturais e a análise de sistemas complexos, a entropia fornece uma lente poderosa para interpretar o mundo ao nosso redor.

Compreender a entropia é essencial para qualquer pessoa interessada em ciência, pois ela revela as forças fundamentais que governam a natureza.

Em resumo, a entropia é uma medida da desordem que desempenha um papel crucial na termodinâmica, na química, na física estatística e em muitas outras áreas. Sua compreensão não só é vital para o estudo da energia e da matéria, mas também para a exploração de questões mais profundas sobre a vida, o universo e o tempo.